“人类永远不会嫌网络太快,就像永远不会嫌高铁太快,你只会嫌它慢,希望它更快些。”

一个月内,百度、阿里、腾讯、商汤、讯飞、360等国内大厂扎堆发布“中国版 GPT ”,这家的名字还没记清楚,另一家的又蹦了出来,一时间 AI 大模型“诸神混战”。可实话实说,和 ChatGPT 相比,国内的 GPT 还存在一定差距,但大家对于 AI 的狂热渴求已经被点燃,越来越多的企业意识到,AI 这班车,再不上,就来不及了。

以 GPT 系列模型为代表的大语言模型成为近来最受关注的技术之一。

ChatGPT 凭什么落别人那么远?

模型越大, AI 回馈的效果越好。 OpenAI 的 GPT-1 模型有50亿个参数, GPT-3.5 有1750亿个参数,到现在的 GPT-4 预计将有超过一个T的参数。可以看出参数是成倍甚至成指数级增长。这种增长模型的变化,首先对内存性能有着极高要求,因为训练它需要海量数据,同时需要处理海量数据集;此外,是数据中心的计算能力,还有 GPU 与 CPU 之间的通信;更重要的是网络的带宽,这些因素将决定大语言模型的整体性能。

整体性能决定了大模型运行、训练所需的时长,也决定了对大模型后续调优再训练的周期。比如你的大语言模型训练需要6个月,一年可能最多训练2次,而别人训练只需要2或3个月,一年就可以训练多次,那么最后 AI 的迭代效果是完全不一样的。

如今,不只是提出大语言模型的公司,越来越多的企业已经意识到 AI 可能会优化工作流程或是给客户提供相应的服务,大家纷纷开始尝试做自己的产品。但一旦大家都在这个模型的基础上去做,就会遇到吞吐量和性能的瓶颈。要支撑这么一个大模型做训练,投入成本是非常高的。

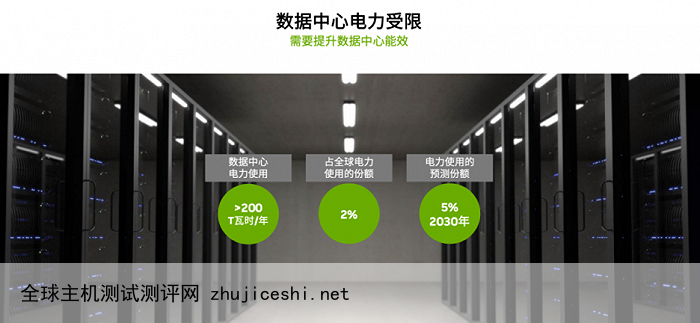

此外还有电力的限制,能做大模型训练的数据中心的功耗和电力需求是非常大的,且增长趋势明显。数据显示,数据中心一年消耗电力200 T瓦时,也就是2000亿度电,占全球电力使用量的2%。2000亿度电是什么概念?2021年我国三峡水电站发电量为1036亿度,也就是三峡水电站两年发的电量才够全球数据中心用一年。而随着 AI 数据中心的部署和持续增长,到2030年,全球电力使用的预测份额将达到5%,这将为全球能源、环保、碳排放等带来巨大挑战。

在 AI 的竞赛中,有两种方式:第一种是用资源去堆,就像造车一样,后造车的永远要比先造车的人烧更多的钱去打市场;第二种是在同等资源下,比谁快,快就需要效率,而提高效率就需要 DPU 。

微软此前发布的博客透露了 OpenAI 的 ChatGPT 采用的硬件是基于 NVIDIA 智能网卡和 InfiniBand 200G 网络所做的产品,未来也有意部署 DPU 。

而为了应对 AI 模型训练、推理带来的需求和挑战, NVIDIA 近日发布了其最新一代数据处理器 BlueField-3 DPU ,并宣布全面量产。

NVIDIA 创始人兼首席执行官黄仁勋表示, AI 时代需要云数据中心基础设施来支持非凡的计算需求。“ NVIDIA BlueField-3 DPU 实现了这一进步,将传统的云计算环境转变为加速、节能和安全的基础设施,以处理生成 AI 的苛刻工作负载。”

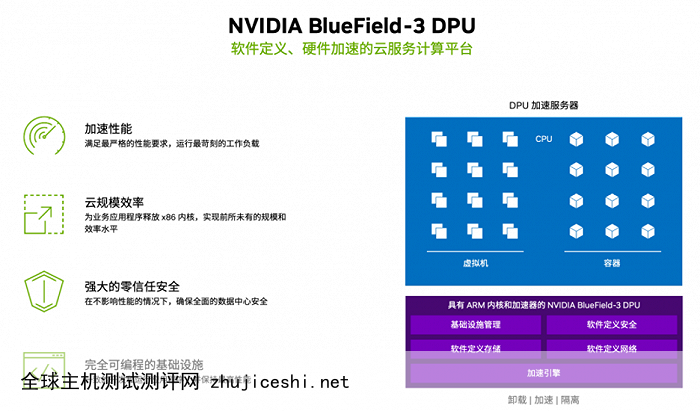

据 NVIDIA 介绍, BlueField-3 DPU 是一款专为数据中心设计的、软件定义、硬件加速的云服务计算平台。它集成了高达16个计算核心,可提供高达400Gbp/s的网络带宽,并且支持多种协议和功能,包括网络虚拟化、弹性负载均衡、数据中心互连等。 BlueField-3 DPU 还拥有世界领先的存储加速功能,可提供高达1.6Tbp/s的存储带宽,并支持 NVMe-over-Fabric 和 RDMA 等高性能存储协议。

大语言模型背后的硬件构成是怎样的?各家都不同。以 NVIDA DGX 为参照,支持大语言模型的服务器由8颗 NVIDIA 高性能 GPU 、4个 NVIDIA NVSWITCHES 、2颗x86 CPU、9块 NVIDIA BlueField-3 DPU 、2T DDR5内存、PCIe Gen5.0,以及服务器间的 NVIDIA Quantum-2 InfiniBand 网络构成。

其中 NVIDIA BlueField-3 DPU 发挥了怎样的作用?首先是加速性能:NVIDIA BlueField-3 DPU 具有丰富的硬件加速器,可以满足大语言模型严格的性能要求,并运行苛刻的工作负载;其次,云规模效率:NVIDIA BlueField-3 DPU 可以释放 CPU 核心,使大语言模型应用具有更好的性能和可扩展性,提升服务器的效率和能效,降本增效;第三是强大的零信任安全:安全的基础设施都可以运行在 NVIDIA BlueField-3 DPU 之上,并基于此构建零信任安全模型,在不影响性能的情况下,确保数据中心安全;第四是完全可编程的基础设施:NVIDIA DOCA 2.0 体现了 NVIDIA BlueField-3 DPU 的软件可编程性,借助 NVIDIA BlueField-3 DPU 可以获得完全可编程的加速数据中心平台。

简单地说,NVIDIA BlueField-3 DPU 可以提升整个网络性能,配合高算力 GPU ,可以支撑更大规模的大语言模型训练,从而缩短训练时间。根据模型需求动态调整部署以共享算力资源,并应对不同规模的模型训练;提升服务器能效、释放算力资源,用更少的服务器完成更多的任务,从而帮助企业实现节能环保、降本增效。

据 NVIDIA 介绍,大语言模型和生成式AI主要会构建在云基础设施之上,以云服务的方式服务于市场,因此,DPU 会主要应用于云服务提供商、AI 技术公司以及采用 AI 技术的企业。据悉,NVIDIA BlueField-3 DPU 已经在部分国内公有云服务提供商进行测试,后续会逐步开始采用。

在不久前的 GTC 2023 大会上,NVIDIA 创始人兼首席执行官黄仁勋先生坚定表示“ AI 迎来了‘ iPhone 时刻’”,回想当年苹果手机刚问世,当时的用户还都想着手机不就是用来打电话、发短信的?而今天,我们几乎已经遗忘了当时的想法和其他手机。同样,你会发现生活将慢慢被 AI 改变。

0 留言