站长之家4月4日 消息:即将到来的强大AI聊天机器人时代很可能会以激进和不可预见的方式重塑世界,但同时也可能也会付出巨大的环境代价。

日前,斯坦福大学人工智能研究所发布的一份新报告估计,训练像OpenAI的GPT-3这样的人工智能模型所需消耗的能量,足以可以让一个普通美国家庭用上数百年了。在研究中审查的三种人工智能模型中,OpenAI 的系统是迄今为止最耗能的。

ChatGPT耗能严重

这项研究在斯坦福最近发布的人工智能指数中得到了强调,该研究借鉴了最近测量与训练四种模型相关的碳成本的研究:DeepMind 的 Gopher、BigScience inititiaives 的BLOOM、Meta 的 OPT和OpenAI 的 GPT-3。据报道,OpenAI 的模型在训练期间释放了502公吨碳。它释放的碳含量是 Gopher 的1.4倍,是 BLOOM 的20.1倍。GPT-3的耗电量也是最大的,达1,287MWh。

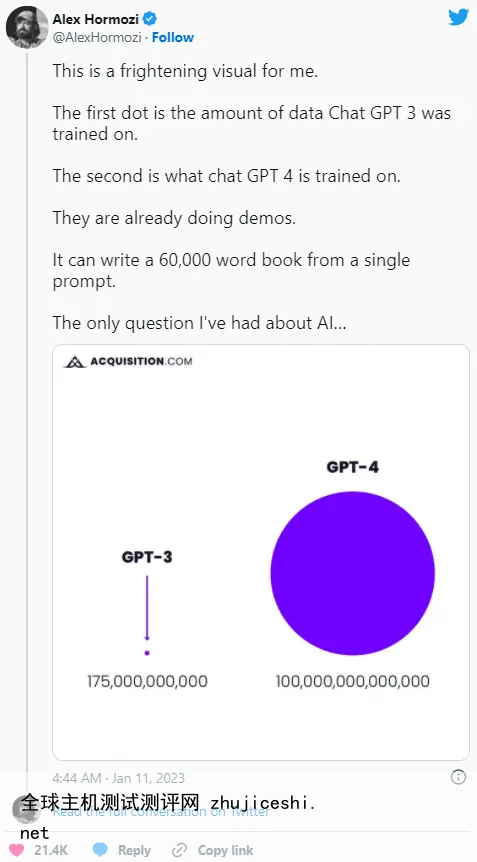

每个模型的能耗受很多因素影响,包括数据点或参数的数量,它们接受的培训以及它们所在的数据中心的能效。尽管能耗存在明显差异,四个模型中有三个(DeepMind的Gopher除外)都是在大致相当的1750亿个参数上进行训练的。OpenAI并没有透露其新发布的GTP-4训练了多少参数,鉴于该模型前几个版本之间所需数据的巨大飞跃,可以肯定GTP-4比之前的版本需要更多数据。

一位人工智能爱好者估计,GPT-4预计用100万亿个参数进行训练,不过OpenAI首席执行官萨姆·奥特曼后来称这个数字“完全是胡扯”。

斯坦福大学研究员彼得·亨德森去年表示:“如果我们只是扩大规模而不考虑对环境的影响,可能会让自己陷入一种对机器学习模型弊大于利的境地。真的希望尽可能减轻这种影响,并带来净社会效益。”

毫无疑问,人工智能模型训练非常依赖数据,但斯坦福大学的报告指出,现在说这是否一定意味着会带来一场环境灾难还为时过早。未来强大的人工智能模型可以用来优化数据中心和其他环境的能耗。例如,在一项为期三个月的实验中,DeepMind的BCOOLER代理能够在谷歌数据中心实现约12.7%的节能,同时仍然保持建筑物足够凉爽,以便人们舒适地工作。

AI的环境成本反映挖矿带来的气候困境

这些听起来是不是很熟悉?那是因为几年前,我们基本上看到了同样的环境动态,即加密货币和web3技术带来的困扰。比如,比特币成为该行业明显的环境痛点,因为在其工作量证明模型中,挖矿需要大量能源。据估计,仅比特币一项每年所需的能源就超过了挪威全年的用电量。

多年来环保人士的批评也促进了加密行业做出了一些改变。以太坊是区块链上的第二大货币,去年正式转向权益证明模型,支持者声称该模型可以将其功耗降低99%以上。其他较小的代币在设计时也同样考虑到了能源效率。从大局来看,大型语言模型仍处于起步阶段,它的环境影响尚不能确定。

大型语言模型训练越来越贵

能源需求并不是新LLM(大语言模型)快速增长的唯一数字,它所需投入的资金量也是如此。2019年OpenAI发布GPT2时,斯坦福大学的报告指出,该公司仅花费5万美元就训练了基于15亿个参数构建的模型。仅仅三年后,谷歌就发布了自己强大的PaLM模型,该模型根据5400亿个参数进行了训练,而花费的金额已经飙升到800万美元。根据这份报告,PaLM比GPT-2大360倍,但价格却高出160倍。同样,这些模型,无论是OpenAI还是谷歌发布的,都只会越来越大。

报告指出,“总整体说,大型语言和多模态模型变得越来越大,越来越贵”。

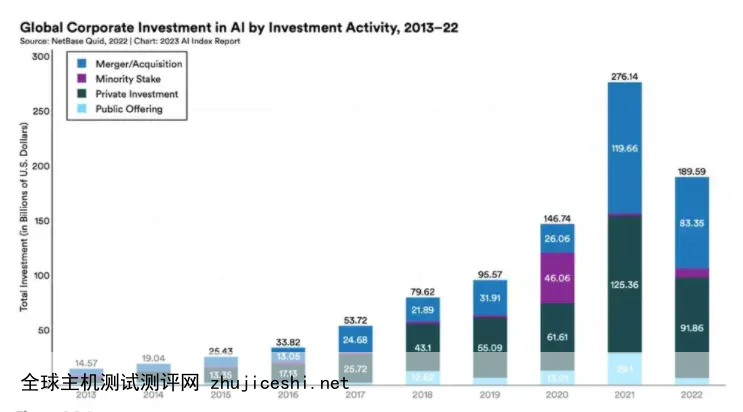

斯坦福大学估计,2022年全球人工智能私人投资额是2013年的18倍。至少在美国,各个行业与人工智能相关的职位招聘也在增长,并在2022年从1.7%增长到1.9%。在全球范围内,美国在人工智能的整体投资方面遥遥领先,据报道,2022年美国对人工智能技术的投资为474亿美元,是中国的3.5倍。说到烧钱,美国无人能及。

针对AI的立法问题

最近一波强大的聊天机器人,以及围绕它们的道德和法律问题,悄悄困扰着人工智能工程师之外的几乎所有人,包括立法者。

可以肯定的是,立法者正试图在立法上迎头赶上。根据斯坦福大学的报告,2021年,所有涉及人工智能的联邦法案中,只有2%真正成为法律。这一数字去年攀升至10%。许多类似的法案是在当前围绕GPT4和一些研究人员过早地将其描述为“人工通用智能”之前写的。

立法者对人工智能也比以往任何时候都更感兴趣。2022年,斯坦福大学确定了110起在美国联邦和州法院提起的人工智能相关法律案件,这比2016年发现的案例多出6.5倍。这些案件大部分发生在加利福尼亚州、伊利诺伊州和纽约州。大约29%的人工智能案件涉及民法,而19%涉及知识产权。如果最近作家和艺术家对AI生成器使用他们的风格提出的投诉有任何指导意义,那么产权案件的比例可能会增加。

0 留言