SEO网站内容应该怎么做?有没有好用的万能采集工具?纯采集的网站会不会被百度的搜索引擎严厉打击?有没有什么方法可以快速提高网站排名或者收录以及网站流量的方法?这是很多做站的朋友经常遇到的问题。

人们都知道百度等搜索引擎是严厉打击纯采集的网站,严重的情况甚至会K站。针对纯采集站,百度也出了飓风算法来打击纯采集垃圾站。因此站长们的出路在哪里?

网站还能不能采集?

必须可以采集。你想大部分站长都是不止一个网站,网站的每天的更新如果都是通过手动的形式进行更新,这是一件不可取的事情。那到底应该怎么做网站内容呢?毕竟SEO是内容为王的时代,好的稳定的内容来源,对一个网站的SEO作用不可估量。

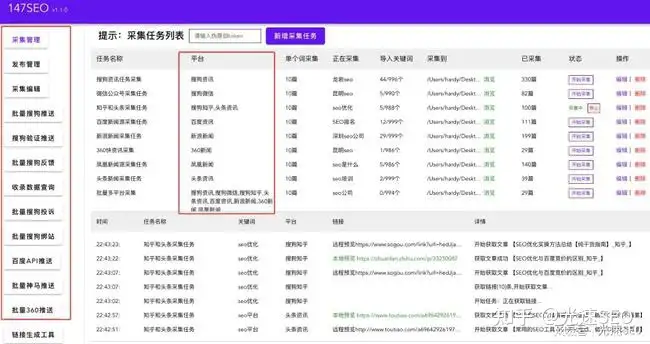

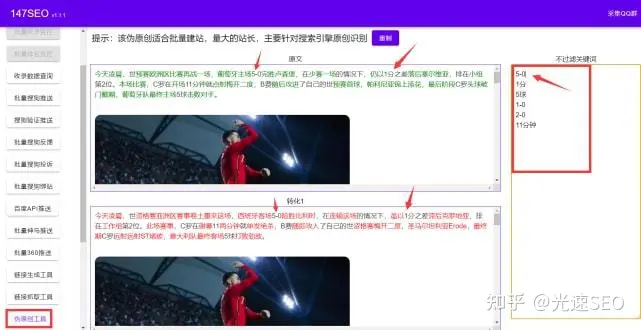

采集应该怎么做?首先我们采集的内容来源质量要高,比如可以针对常见的新闻源进行采集。如我们可以选择搜狗资讯、搜狗微信、搜狗知乎、头条资讯、百度资讯、百度知道、新浪新闻、360资讯、凤凰新闻等高质量的新闻源进行内容采集。还有一个点就是规避纯采集的方法我们对采集过来的文章进行批量伪原创然后进行发布。

万能采集工具怎么选择?

首先我们通过采集来的内容能够经过伪原创处理之后再发布。然后使用要简单方便,不能像火车头写规则和复杂的配置,大部分站长技术和代码能力不强甚至不会的,要适合大众。三是要可以一直挂机使用,这样才能满足多个网站的更新频率以及内容丰富度。小编现在一个人做几十个站,全靠147SEO站长工具来进行网站的采集伪原创发布以及推送,大多数站点的收录情况还是不错的,收录做起来的站点排名也在慢慢往上升,总体情况还是非常不错的。

当我们的网站长期处于采集状态时,我们网站上更新的大部分文章在互联网上都是相同的内容。而且如果网站权重不高,那么蜘蛛很可能会把你的网站列为采集站。文章页面肯定会停止收录,快照也将停滞不前,网站收录将开始减少。所以解决方案一定要伪原创,发布的内容一定要第一时间主动推送,让搜索引擎快速找到你更新的页面。

搜索引擎蜘蛛会抓取,但不会收录你的网页。其实在蜘蛛抓取的时候就已经进行了检测。当蜘蛛抓取和抓取文章时,它会进行一定程度的复制内容检测。当它发现你的内容和互联网高度重复时,这就是为什么在日志中发现蜘蛛的原因。但是页面一直没有被收录,因为抓取发现了重复的内容。那么他就会放弃抓取,也就是只停留在查询阶段。解决方案和上一个一样,你必须保持你的内容原创而不是同质化。

排名上不去,再长也不稳定。更新后的伪原创文章收录后,排名上不去。搜索看到所有从其他网站转发的文章。连排名都上升了,也不稳定。一天后,排名再次下降。在这种情况下,您需要仔细检查您网站上的文章是否长期被他人采集?

0 留言