当地时间7月2日凌晨1点35分开始,日本运营商KDDI的移动网络发生大规模通信故障,导致全日本范围内无法拨打电话、无法收发短信、数据通信变慢。

此次事故影响范围大,持续时间长,影响用户数量达3915万,故障一直持续到7月4日下午才基本完全恢复,给日本全社会造成了极大的不便和损失,也是KDDI有史以来遭遇的最大一次网络系统故障。

故障发生后,KDDI高层及时召开新闻发布会,向广大深受影响的个人和企业用户鞠躬致歉,并表示考虑赔偿损失。

那究竟是什么原因造成了此次大规模通信故障?看完KDDI的报告后,发人深省。

故障原因一:

核心路由器割接失败

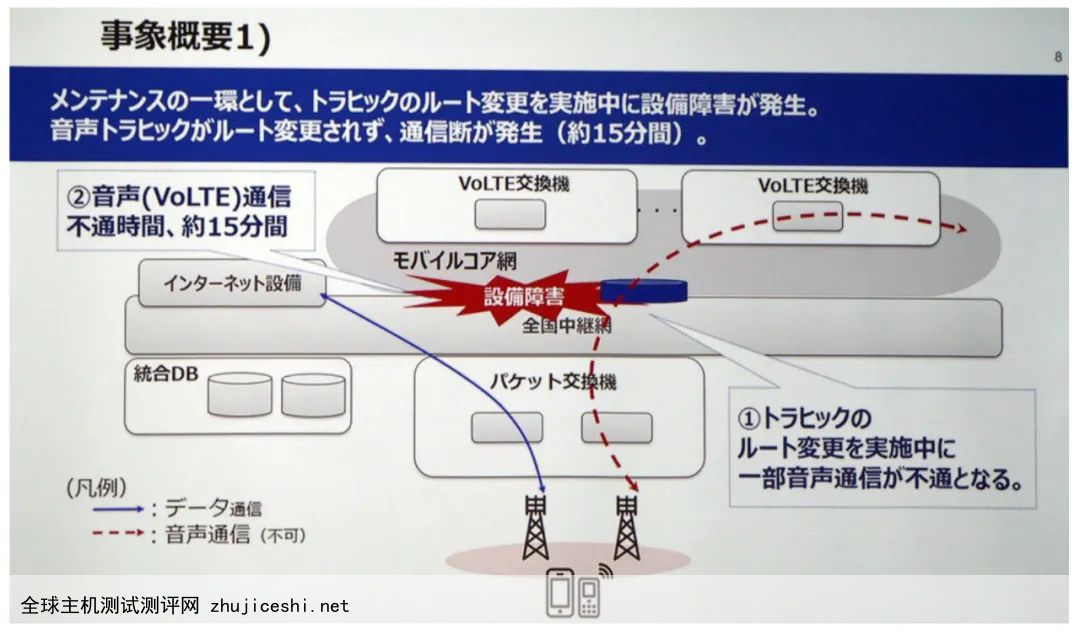

7月2日凌晨,KDDI组织工程师对连接全国移动核心网和中继网络的一个核心路由器进行割接,将老旧的核心路由器更换为新产品。

不幸的是,通信人最担心的噩梦发生了——割接失败了。在更换核心路由器的过程中,新的核心路由器出现了不明原因的故障。

搞通信的伙伴们都知道,核心路由器位于网络核心位置,是整个网络的“交通枢纽”,不仅性能强悍、价格昂贵,且需时时刻刻保持稳定运行,否则,一旦出现问题,动辄可能影响全网数百万甚至数千万用户。

正因如此,核心路由器割接好比为活人换“心脏”,是一项极具挑战的工作,也对要更换的新产品的成熟性、稳定性、互联互通性等能力要求极高。

但KDDI偏偏在这项要求极其谨慎的工作上掉了链子,接下来的后果当然就相当严重了——

由于新核心路由器无法将语音流量正确路由到VoLTE交换节点,直接导致部分VoLTE语音业务中断15分钟。

故障原因二:

信令风暴击溃VoLTE网络

核心路由器割接失败,这场景简直不敢想象,隔着屏幕都能吓出冷汗!

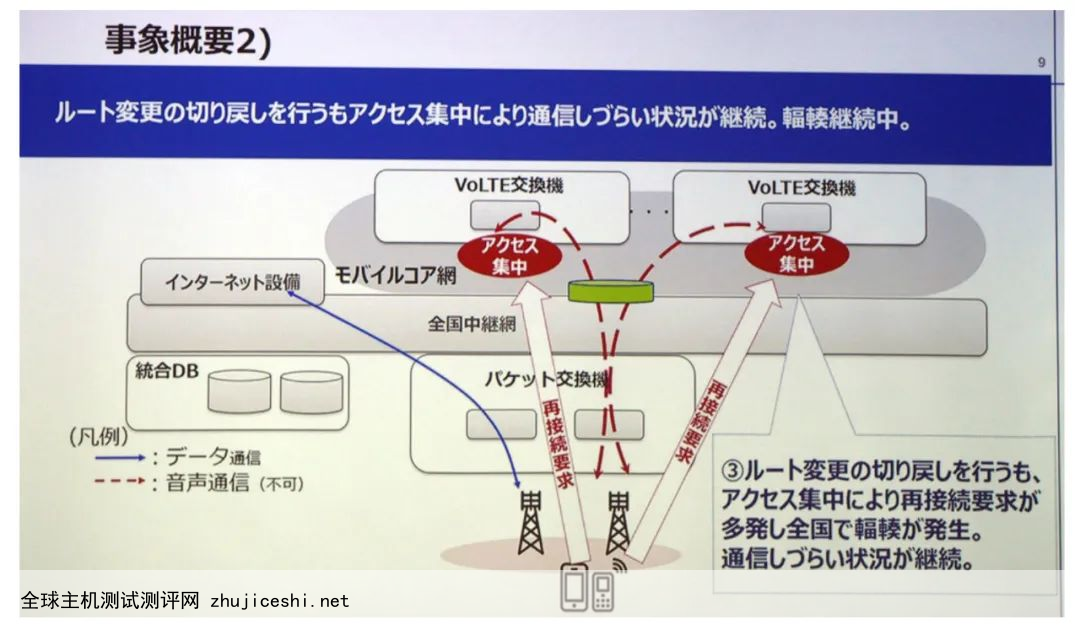

怎么办?赶紧回退呗。KDDI的工程师们快速启动了回退操作,于7月2日凌晨1点50分将连接重新切换回旧的核心路由器。

但更大的问题发生了。

回退后,“由于VoLTE终端每50分钟进行一次位置注册”,大量终端向VoLTE交换节点发起位置注册信令,以重新连接至网络。海量信令集中突发,很快引发VoLTE交换节点拥塞,致使大量用户无法进行VoLTE通信。

同时,移动网络中有一个“用户数据库”,负责存储用户的签约数据和位置信息,由于VoLTE交换节点拥塞,“注册在用户数据库的位置信息无法反映在VoLTE交换机上”,出现数据不匹配问题,也导致很多用户无法通信和拨打电话。

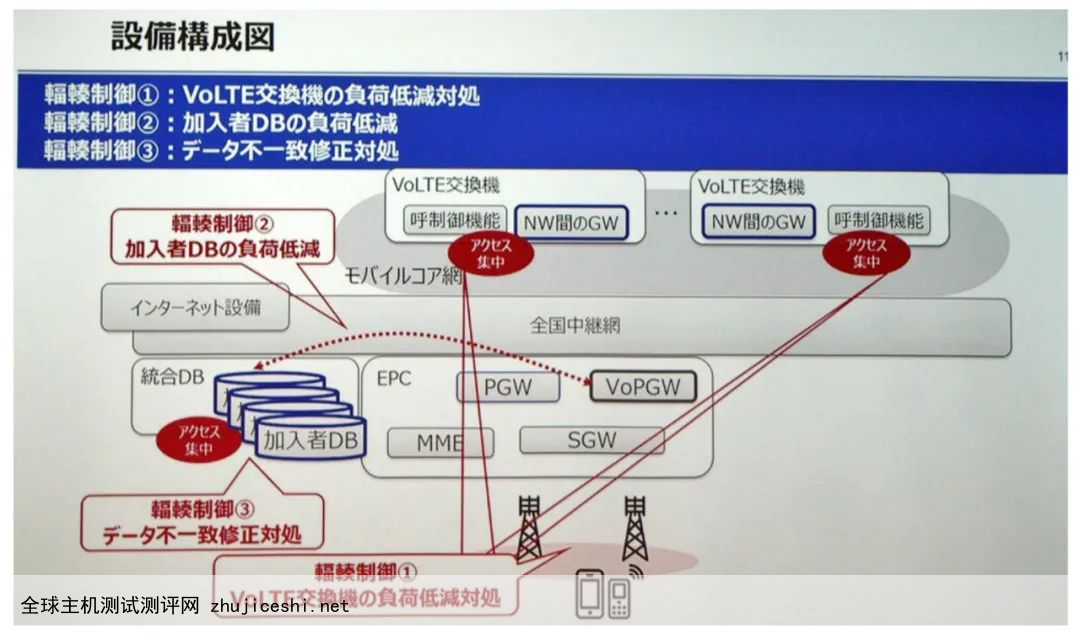

针对此情况,KDDI于7月2日凌晨3:00后开始从无线侧、VoLTE核心网侧同时实施流量控制策略,以及通过断开PGW的方式减轻用户数据库负荷,以缓解网络拥塞,并在PGW采用“会话重置”措施解决用户数据库中的数据不一致问题。

因为实施流量控制,接下来导致了全国范围内的数据通信和语音通话难以连接。

接下来,KDDI开始紧张的网络恢复工作。7月3日上午11点,KDDI宣布日本西部基本完成网络修复工作。下午5点30分,日本东部基本完成。但仍然有一些用户难以进行数据通信和语音通话。

直到7月4日下午4点,距离故障发生62个小时后,KDDI表示已在全国范围内基本恢复。

发人深省

类似的重大网络故障在日本并不是头一次。

2021年10月14日,日本另一家运营商NTT DoCoMo的移动网络也发生过全国性的重大通信事故,导致大量手机用户无法进行通话和数据通信。

此次事故同样因为割接失败后回退操作,引发信令流量大爆发,导致网络大拥塞。

具体情况是,NTT DoCoMo在替换用于存储物联网终端设备的用户和位置信息的网络设备时出现了问题,然后立即启动回退操作,重新倒回到旧设备。

但这一回退操作,引发了大量物联网终端向旧设备重新发起位置注册信息,汹涌而来的“信令风暴”快速引发了网络拥塞,并波及3G/4G/5G网络的语音和数据分组核心设备,导致大量用户无法通话和数据通信。

与NTT DoCoMo不同的是,KDDI此次是因为核心路由器割接失败引起,而且故障持续时间要长很多。

但值得一提的是,KDDI似乎并非没有吸取DoCoMo的教训。

KDDI在全日本范围内拥有6个交换中心,共18个VoLTE交换节点,且交换中心内的VoLTE交换节点是相互冗余备份的。而本次因核心路由器割接导致VoLTE业务中断的只是其中一个交换中心的VoLTE交换节点。

“我们做过压力测试,因为有冗余备份,即使一个交换中心范围内的所有终端同时发起重新连接请求,也不会发生拥塞。”

KDDI表示,“但不知道什么原因,结果还是发生了拥塞,我们还没有完全搞清楚到底是哪里出了问题。”

但愿KDDI最终能彻底找出此次事故的所有原因。也希望通信业再也不要重蹈覆辙。因为,重大网络故障,这六个大字,对于通信业而言,实在太可怕了。

0 留言