今日,算力、云服务板块全线爆发,截止收盘,青云科技涨超20%、寒武纪涨17.07%、光环新网涨16.35%、中富通13.37%、拓维信息10.02%、鸿博股份、优刻得涨超9%、中科曙光、顺网科技涨超7%、初灵信息、神州数码、立方数科、南陵科技等跟涨。

消息面上,英伟达推出面向大语言模型和生成式AI的云服务产品,针对算力需求巨大的ChatGPT,英伟达发布了Nvidia H100 NVL,与谷歌云、微软Azure、甲骨文云联手推出DGX(AI超级计算机)云服务。

另外,据市场消息,英伟达表示已将其旗舰产品修改为可合法出口中国的版本,可替代被新规限制出口的A100。公司也已开发出可出口中国的H100替代版本,该版本名为H800,目前正被阿里巴巴、百度和腾讯等企业的云计算部门使用。

值得关注的是,今年的政府工作报告曾明确提出,要大力发展数字经济。而作为“数字经济”的技术底座之一,算力服务俨然会迎来新的发展高峰期。

算力板块获高度重视

算力决定了数字经济发展速度,以及社会智能发展高度。

根据IDC、浪潮信息、清华大学全球产业研究院联合发布的数据显示,计算力指数平均每提高1点,数字经济和GDP将分别增长3.5‰和1.8‰。

截至2022年底,全国在用数据中心机架总规模超过650万标准机架,算力总规模达到180EFLOPS,位居全球第二,算力总规模近五年年均增速超过25%,存力总规模超过1000EB。当前的算力规模中,有超过20%的算力是智能算力,可用于人工智能各类应用,包括模型训练和推理。

据央视新闻报道,“东数西算”工程从系统布局进入了全面建设阶段。截至目前,“东数西算”工程的8个国家算力枢纽节点建设已全部开工,2023年新开工的数据中心项目近70个,其中,西部新增数据中心的建设规模超过60万机架,同比翻了一番。

“东数西算”工程自启动至今,全国新增投资超过4000亿元,整个“十四五”期间,将累计带动各方面投资超过3万亿元。

此外,数据中心作为“东数西算”工程的重要核心构成,也是算力最重要的物理承载基础,近来也是备受国家支持。

今年2月发布的《数字中国建设整体布局规划》中明确指出,要夯实数字中国建设基础,系统优化算力基础设施布局,促进东西部算力高效互补和协同联动,引导通用数据中心、超算中心、智能计算中心、边缘数据中心等合理梯次布局。

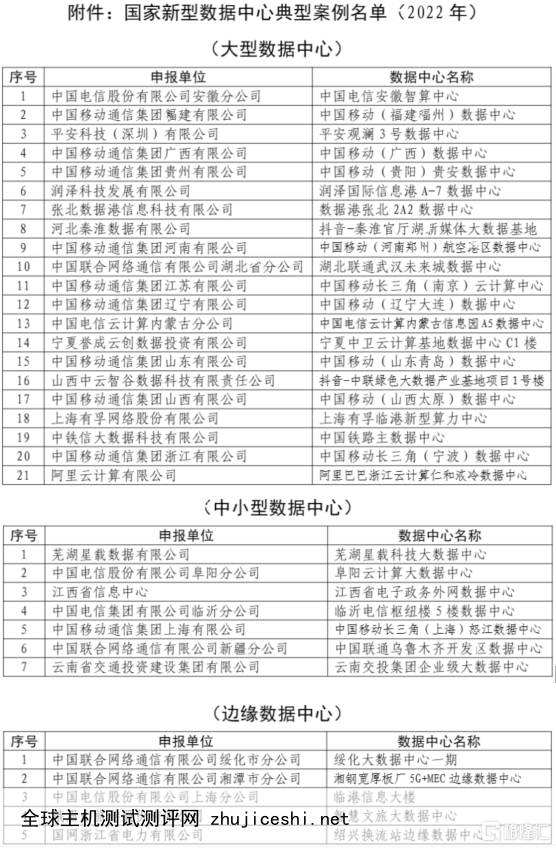

3月16日,工业和信息化部公示2022年国家新型数据中心典型案例名单,共有33家数据中心入选。其中,大型数据中心21家,针对互联网、工业、金融、政务等重点行业领域,聚焦数据中心基础设施、运营管理、数字技术、生态能力,特别是在支撑行业数字化转型、赋能千行百业两方面效果明显的大型及以上数据中心典型应用案例。

GPT4.0更大模型对算力提出更高需求

最新发布的GPT-4是一个大型多模态模型,接受图像和文本输入,然后进行文本输出,它在管理文字从属性、一致性和常识推理方面的能力都有了大幅提高。

可以确定的是,未来,GPT-4将带来更为丰富的应用场景。

然而,伴随参数规模增速的不断提升,算力和训练成本仍存在瓶颈。根据行业调研信息,AI训练的算力增长符合摩尔定律,大约每20个月翻一番;深度学习用于AI训练的算力大约每6个月翻一番;而目前大规模模型的训练算力是原来的10到100倍。

在大模型训练时,微软专门打造的超级计算装置训练成本约500万美元/次,并且不同的并发用户数,这个阶段的花费弹性巨大,难以预估。据统计,ChatGPT每日推理成本在28万美元左右。

如何在AI算力上实现技术突破、降低成本、扩大规模,提升AI训练的边际效益,将成为技术创新的焦点。

而此次,针对算力需求巨大的 ChatGPT,英伟达发布的 NVIDIA H100 NVL与当前唯一可以实际处理ChatGPT的 HGX A100相比,速度快上10倍,可以将大语言模型的处理成本降低一个数量级。

中信建投研报认为,从语言模型走向多模态模型,GPT-4将带来更为丰富的应用场景。算力硬件作为AI大模型基础设施,未来将持续受益于AI技术的迭代和商业化应用。随着GPT4.0更大模型对算力提出更高需求的同时,多模态特性又增加了对其他编解码模块的需求。展望未来,多模态应当具备三个基本组成部分,第一部分是图像,视频为多帧的图像;第二部分为音频;第三部分为文字。因此,随着多模态的发展,在硬件算力层面,需要面向视频、音频再增加编解码能力的支持。建议关注从GPU算力扩展到GPU周边支持性的编解码IP如VPU模块的机会。

在全球数据总量和算力规模呈现高速增长态势下,中信证券表示,AI发展快速拉升算力需求,云厂商具有较高确定性会受益。AI大模型训练环节的海量参数、数据库以及用户调用次数的快速增长,均带来了算力需求的激增。考虑到资源优势及经济性,云厂商有望成为AI算力需求的主要承载方,如微软是OpenAI的独家云服务提供商,Anthropic将谷歌云作为首选的云提供商。国内互联网云厂商在数据库、弹性计算等方面已积累深厚优势,亦有望受益于国内AI产业蓬勃发展带来的训练及应用环节的增量算力需求。

0 留言